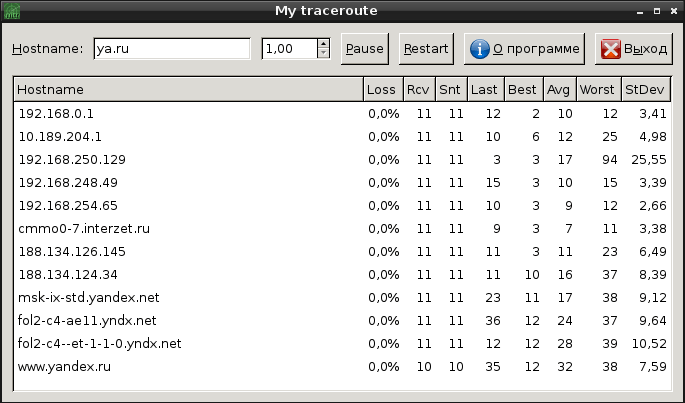

Программа MTR (сокращенно от My TraceRoute) — это программа для мониторинга прохождения пакетов, позволяющая определить узел, на котором происходят потери пакетов. Кроме простоты использования ее также отличает наличие как графического интерфейса, так и текстового, поэтому ее удобно использовать как на десктопных конфигурациях, так и на серверах без графической подсистемы. Читать далее «Мониторинг сети при помощи MTR»

линукс

15 малоизвестных команд Linux

Независимо от того, новичок вы или гуру, уверен, вы найдете для себя полезное среди нижеприведенных советов и рекомендаций. Читать далее «15 малоизвестных команд Linux»

Netcat: Примеры использования

Netcat – утилита Unix, позволяющая устанавливать соединения TCP и UDP, принимать оттуда данные и передавать их. Несмотря на свою полезность и простоту, данная утилита не входит ни в какой стандарт.

Netcat является своего рода швейцарским ножом при работе с TCP/IP и в руках знающего человека является грозным и крайне полезным оружием. Читать далее «Netcat: Примеры использования»

Установка Samba и привязка к AD в CentOS 6.x

Сейчас быстренько за 5-10 минут развернем файловый сервер на Samba 3 с доменной авторизацией (через ActiveDirectory).

Читать далее «Установка Samba и привязка к AD в CentOS 6.x»

Ротация логов в Linux: logrotate

logrotate — обращение, сжатие, и отправление электронной почтой файлов системных сообщений Читать далее «Ротация логов в Linux: logrotate»

Ошибка 414 Request URI Too Large в Nginx

Ошибка 414 Request URI Too Large возникает в тех случаях, когда веб-сервер не способен обслужить запрос от клиента (т.е. веб-браузера или робота), потому что запрашиваемый URI (Request URI) длиннее, чем сервер может интерпретировать. Говоря простым языком, запрашиваемый веб-адрес слишком длинный, то есть содержит слишком много байтов. Читать далее «Ошибка 414 Request URI Too Large в Nginx»

Ошибка 504 Gateway Time-out в Nginx

Ошибка 504 gateway time-out возникает, когда Nginx не может достаточно долго получить ответ от какого-либо сервиса. Например от PHP-FPM. Читать далее «Ошибка 504 Gateway Time-out в Nginx»

Как исправить ошибку 413 Request Entity Too Large в Nginx

Ошибка появляется при загрузке файлов больше 1 мегабайта. Одна из причин — это дефолтные настройки nginx, а точнее параметра client_max_body_size, который по умолчанию равен 1mДиректива client_max_body_size задаёт максимально допустимый размер тела запроса клиента, указываемый в строке «Content-Length» в заголовке запроса. Если размер больше заданного, то клиенту возвращается ошибка «Request Entity Too Large» (413). Следует иметь в виду, что браузеры не умеют корректно показывать эту ошибку. Читать далее «Как исправить ошибку 413 Request Entity Too Large в Nginx»

Немного о Xargs

Об утилите xargs написано очень много — что можно написать еще? Но если, что называется, копнуть поглубже, то выясняется, что во многих публикациях излагаются лишь самые основы, но нет главного: не объясняется, как можно применять xargs в реальной практике. Статей с разбором сложных и нетривиальных вариантов применения этого весьма полезного для системного администратора инструмента, к сожалению, очень мало. Именно поэтому мы написали свою статью и постарались включить в нее как можно больше примеров использования xargs для решения различных проблем.

Сначала мы рассмотрим принцип работы xargs и разберем примеры попроще, а затем перейдем к разбору сложных и интересных кейсов. Читать далее «Немного о Xargs»